基因测序性能提升5倍,华为云FPGA基因加速方案彰显技术创新能力

近期,华为云携手峰科计算(以下简称“峰科”)发布基于FPGA的基因加速云解决方案,该方案采用GATK(The Genome Analysis Toolkit)标准分析流程,将全基因组测序(WGS)性能提升5倍,比传统模式提升3~5倍,同时测序精度可达99.95%以上,在大幅缩短测序时间的同时实现TCO大幅降低。

基因测序数据分析加速面临的挑战

首先,基因测序分析流程BWT+GATK当前被业界广泛采纳,但采用此流程的传统测序方法需要消耗高额算力及存储资源,且耗时较长。

其次,针对基因测序中高算力需求的smith-waterman,pair-hmm等算法处理,其具有计算并行性,不连续,非规则的存储访问,低bit操作等特性,计算依赖不规则区域的操作会对CPU消耗很大,性能难以提升。

华为云FPGA基因加速解决方案的三大优势

为了更好的解决基因测序行业面临的基因组分析标准流程不经济高效,以及跨不同云和硬件(CPUs,FPGAs)加速实现的双重挑战。华为云和峰科计算强强联合,合作推出符合行业标准的GATK加速流程,通过对基因测序数据分析流程进行软、硬件联合优化实现端到端加速。华为云FPGA基因加速方案具备如下优势:首先,华为云提供业界领先的FPGA加速云服务平台,采用业界领先的Xilinx 16nm Virtex UltraScale+ VU9P FPGA,并针对基因场景推出32核CPU224GB内存1 VU9P FPGA和64核CPU448GB内存2 VU9P FPGA规格的实例,实现了GATK 软件处理流程和FPGA加速流程的完美结合,从而将加速效率提升3~5倍。

其次,峰科采用GATK标准分析流程,精准性与GATK标准流程完全吻合,精度可达99.95%以上。

第三,不修改GATK标准流程,可访问读取从原始测序数据到生成vcf文件整个过程中的中间数据,便于科研用户使用比对。

- 华为云FPGA基因加速解决方案解析

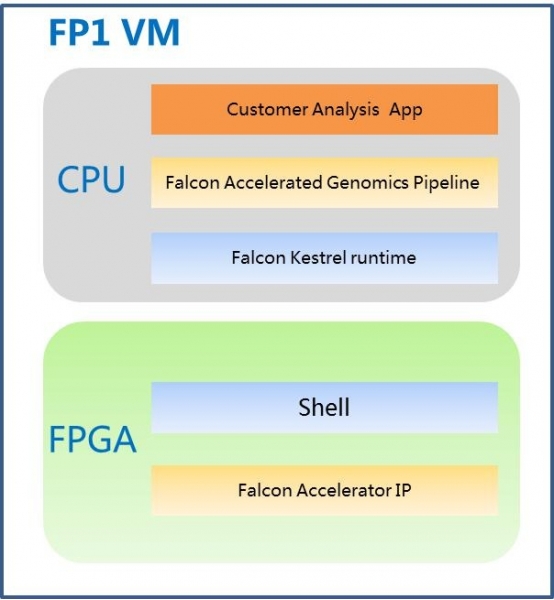

华为云FPGA基因加速解决方案集成峰科的加速IP,为用户提供一种易于使用,经济实惠的基于FPGA的基因组分析流程加速服务,在该方案中,华为云配备了32核CPU,单个VU9P FPGA的实例。华为云FPGA基因加速解决方案使用GATK最佳方案对种系突变和体细胞突变进行变异检测,将计算密集型算法如Smith-Waterman、PairHMM等确定为加速对象。每种算法都经过FPGA内核优化,并且实现CPU-FPGA协同执行和资源分配。如图2所示,用户通过分析应用程序,把每个流程的数据传给华为云峰科加速平台,平台里的Kestrel运行时管理工具来管理CPU-FPGA协同执行和资源分配。利用多线程,I / O优化和扩展使用FPGA加速器,华为云FPGA基因加速服务的基因组学分析流程在保证精准度情况下提供显著的加速。

图1 华为云FPGA基因加速方案结构图

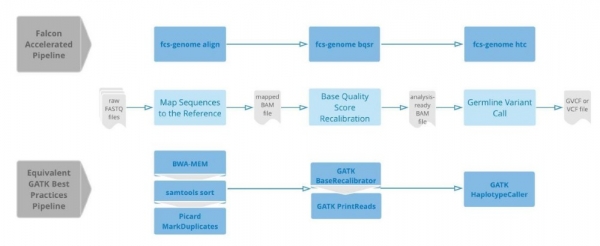

与GATK 最佳使用流程相对称,典型的基因测序数据分析流程始于原始FASTQ序列两端读长(paired-end reads),进一步获取一组经过滤的变体,对其进行标记以供进一步分析。图3描述了华为云基因加速服务种系变异调用流水线的具体流程,中间面板指示开始的通常工作流程,上下分别显示华为云FPGA基因加速方案中的峰科加速流程和GATK最佳使用流程命令实现方式的工作流程。

图2 华为云峰科基因加速流程和GATK最佳使用流程对比

基于华为云FPGA加速服务,使用FPGA优化加速GATK流程,基因组分析流程可以实现3~5倍速度提升和99.95%以上的准确度。华为云FPGA基因加速解决方案最快基因组序列分析标准流程可在一天内完成5个全基因组或24个整体外显子组分析。

Performance comparison for GATK 3.8 WGS from Alignment to Variant Calling using Hoplotypecaller

|

Cloud based comparison |

Total(Hrs.) |

Speedup |

|

|

WGS(30X) |

Falcon on Huawei |

7.46 |

4.84x |

|

Original |

36.1 |

1x |

|

注:测试数据使用的是30X的WGS样本,碱基数量103G华为云基因加速服务“0”元体验

为了能让更多的用户体验华为云FPGA加速云服务器,针对基因加速场景,华为云联合峰科(Falcon)推出“基因加速服务0元体验套餐”,套餐规格为32核CPU224GB内存500GB数据盘5M带宽,欢迎各企业登录华为云官网使用。“基因加速0元体验”套餐试用方法如下:

https://bbs.huaweicloud.com/forum/thread-8733-1-1.html

好文章,需要你的鼓励

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

很多人担心被AI取代,陷入无意义感。按照杨元庆的思路,其实无论是模型的打造者,还是模型的使用者,都不该把AI放在人的对立面。

MIT递归语言模型:突破AI上下文限制的新方法

MIT研究团队提出递归语言模型(RLM),通过将长文本存储在外部编程环境中,让AI能够编写代码来探索和分解文本,并递归调用自身处理子任务。该方法成功处理了比传统模型大两个数量级的文本长度,在多项长文本任务上显著优于现有方法,同时保持了相当的成本效率,为AI处理超长文本提供了全新解决方案。

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

谷歌宣布对Gmail进行重大升级,全面集成Gemini AI功能,将其转变为"个人主动式收件箱助手"。新功能包括AI收件箱视图,可按优先级自动分组邮件;"帮我快速了解"功能提供邮件活动摘要;扩展"帮我写邮件"工具至所有用户;支持复杂问题查询如"我的航班何时降落"。部分功能免费提供,高级功能需付费订阅。谷歌强调用户数据安全,邮件内容不会用于训练公共AI模型。

华为研究团队突破代码修复瓶颈,8B模型击败32B巨型对手!

华为研究团队推出SWE-Lego框架,通过混合数据集、改进监督学习和测试时扩展三大创新,让8B参数AI模型在代码自动修复任务上击败32B对手。该系统在SWE-bench Verified测试中达到42.2%成功率,加上扩展技术后提升至49.6%,证明了精巧方法设计胜过简单规模扩展的技术理念。

联想集团混合式AI实践获权威肯定,CES期间获评“全球科技引领企业”

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

CES 2026 | 重大更新:NVIDIA DGX Spark开启“云边端”模式

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

研究发现商业AI模型可完整还原《哈利·波特》原著内容

Razer在2026年CES展会推出全息AI伴侣项目

CES 2026:英伟达新架构亮相,AMD发布新芯片,Razer推出AI奇异产品

通过舞蹈认识LimX Dynamics的人形机器人Oli

谷歌为Gmail搜索引入AI概览功能并推出实验性AI智能收件箱

DuRoBo Krono:搭载AI助手的智能手机尺寸电子阅读器

OpenAI推出ChatGPT Health医疗问答功能

Anthropic寻求3500亿美元估值融资100亿美元