Azure AI的又一里程碑!Neural TTS新模型呈现真人般情感饱满的AI语音

在人与人之间的对话中,即使是同样的字句,也会因为所处情景和情感的不同而表现出丰富的抑扬顿挫,而这种动态性恰恰是各种AI合成语音的“软肋”。相比于人类讲话时丰富多变的语气,AI语音的“心平气和”往往给人带来明显的违和感。

如何让AI语音有效模仿人类对话的丰富动态与情感,已成为全球研究者的共同挑战。就在不久前,微软Azure Neural TTS(神经网络文本转语音)推出的新一代模型“Uni-TTS v4”在这一领域取得了里程碑式的重大突破。在“2021国际语音合成大赛(Blizzard Challenge 2021)”的测试中,Uni-TTS v4的语音表现与通用数据集上的自然语音相比几乎没有明显差别,展现出足以“叫板”真人对话的实力。

Uni-TTSv4的研究出发点是XYZ-代码,它是三种认知属性的联合表示:单语文本(X),音频或视觉感官信号(Y),以及多语言(Z)。关于这些努力的更多信息,请阅读XYZ-代码的博文。

“耳听”为实,让我们从以下几段TTS和真人对话的对比中,感受新模型带来的逼真语音表现。

En-US(Jenny):

The visualizations of the vocal quality continue in a quartet and octet.

真人录音: https://www.microsoft.com/en-us/research/uploads/prod/2021/12/Jenny_NonTTS-recording.wav

Uni-TTS v4: https://www.microsoft.com/en-us/research/uploads/prod/2021/12/Jenny_TTS_new.wav

En-US(Sara):

Like other visitors, he is a believer.

真人录音: https://www.microsoft.com/en-us/research/uploads/prod/2021/12/Sara-NonTTS-recording.wav

Uni-TTS v4: https://www.microsoft.com/en-us/research/uploads/prod/2021/12/Sara-TTS-new.wav

Zh-CN(Xiaoxiao):

另外,也要规避当前的地缘局势风险,等待合适的时机介入。

真人录音: https://www.microsoft.com/en-us/research/uploads/prod/2021/12/Xiaoxiao-NonTTS-RECORDING.wav

Uni-TTS v4: https://www.microsoft.com/en-us/research/uploads/prod/2021/12/Xiaoxiao-TTS-NEW-Wave.wav

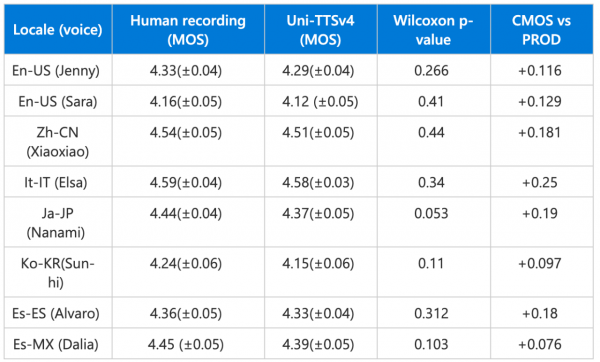

图注:上图为Uni-TTS v4在“2021国际语音合成大赛(Blizzard Challenge 2021)”上的测试结果。这项TTS领域的全球盛事汇集了全球顶级专家,每次都会邀请数百名参会者对多个TTS系统进行大规模MOS测试,称得上是全球TTS“试金石”。相关详细信息可以参看微软为此次活动发表的论文《DelightfulTTS: The Microsoft Speech Synthesis System for Blizzard Challenge 2021》。

如果体验完以上示例后还觉得意犹未尽,欢迎在Azure TTS在线服务中使用自创文本来创建新的demo。目前Uni-TTS v4可支持TTS语言库中7个语种的8个语音,研发团队还将持续使用最新模型优化Neural TTS已支持的其它语言以及自定义神经语音,以便能让用户通过Azure TTS API、 Microsoft Office和Edge browser直接获得更出色的新一代TTS语音。

Uni-TTS v4之所以能成为Azure AI的又一里程碑,在于其出色拟真语音表现的背后,对TTS语音基础建模的大幅革新。

如同开篇所说,TTS语音与真人的差距在于难以模仿人类对话的丰富动态。人类在不同的情绪或场景下,对同一个词的发音方法可能完全不同,而且其变化规律在不同语种中也千差万别。

TTS语音的表现依赖于以各种声学参数进行建模,但这些参数很难有效地对人类语音声学频谱上的所有粗粒度和细粒度细节进行建模。另一方面,TTS是一种典型的一对多映射,往往需要使用多种语音风格(如音调、语速、讲话人、韵律、风格等等)来输出同一个文本内容。总之,能否为这些“变量”进行有针对性的建模,是提升合成语音表现力和真实度的重要因素。

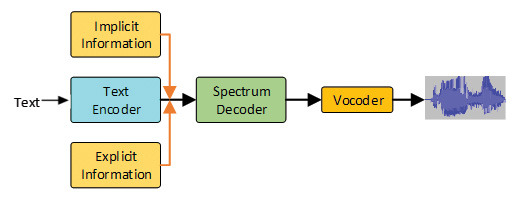

为了让TTS在以上两方面获得提升,Uni-TTS v4在声学建模中引入了两项重要更新。通常,transformer模型用来学习全局交互,而卷积神经网络则有效地发现局部相关性。于是研究团队首先采用了一个带有transformer和卷积块的新架构,以更好地模拟声学模型中的局部和全局依赖关系;其次,从显性视角(身份ID、语种ID、音调、语速)和隐性视角(话语级和音素级韵律)系统地对变量信息进行建模。这些视角分别使用监督学习和无监督学习,确保端到端的音频具有足够自然的表现力。

图注:Uni-TTS v4 的声学模型和声码器示意图。首先使用文本编码器对文本进行编码,然后将隐性和显性信息添加到文本编码器的隐藏嵌入(hidden embeddings)中,再使用频谱解码器预测梅尔声谱图。最后,通过声码器将梅尔声谱图转换为音频样本。

作为微软Azure认知服务中的强大语音合成功能,Neural TTS可用于帮助开发者将文本转换为真人一般的逼真自然语音,常被用于语音助手场景、文字朗读功能,及作为辅助性工具等等,同时也被整合到微软的Edge Read Aloud、Immersive Reader和Word Read Aloud等旗舰产品中,还被AT&T、Duolingo、Progressive等众多客户采用。Neural TTS已拥有330多个音色,支持来自不同国家和地区的近130种语言或方言。用户和企业可以通过搜索"Azure TTS"进入产品网站,测试体验Neural TTS的丰富预设语音,抑或录制并上传自己的样本,来创建独有的自定义语音。

来源:业界供稿

好文章,需要你的鼓励

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

很多人担心被AI取代,陷入无意义感。按照杨元庆的思路,其实无论是模型的打造者,还是模型的使用者,都不该把AI放在人的对立面。

MIT递归语言模型:突破AI上下文限制的新方法

MIT研究团队提出递归语言模型(RLM),通过将长文本存储在外部编程环境中,让AI能够编写代码来探索和分解文本,并递归调用自身处理子任务。该方法成功处理了比传统模型大两个数量级的文本长度,在多项长文本任务上显著优于现有方法,同时保持了相当的成本效率,为AI处理超长文本提供了全新解决方案。

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

谷歌宣布对Gmail进行重大升级,全面集成Gemini AI功能,将其转变为"个人主动式收件箱助手"。新功能包括AI收件箱视图,可按优先级自动分组邮件;"帮我快速了解"功能提供邮件活动摘要;扩展"帮我写邮件"工具至所有用户;支持复杂问题查询如"我的航班何时降落"。部分功能免费提供,高级功能需付费订阅。谷歌强调用户数据安全,邮件内容不会用于训练公共AI模型。

华为研究团队突破代码修复瓶颈,8B模型击败32B巨型对手!

华为研究团队推出SWE-Lego框架,通过混合数据集、改进监督学习和测试时扩展三大创新,让8B参数AI模型在代码自动修复任务上击败32B对手。该系统在SWE-bench Verified测试中达到42.2%成功率,加上扩展技术后提升至49.6%,证明了精巧方法设计胜过简单规模扩展的技术理念。

联想集团混合式AI实践获权威肯定,CES期间获评“全球科技引领企业”

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

CES 2026 | 重大更新:NVIDIA DGX Spark开启“云边端”模式

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

研究发现商业AI模型可完整还原《哈利·波特》原著内容

Razer在2026年CES展会推出全息AI伴侣项目

CES 2026:英伟达新架构亮相,AMD发布新芯片,Razer推出AI奇异产品

通过舞蹈认识LimX Dynamics的人形机器人Oli

谷歌为Gmail搜索引入AI概览功能并推出实验性AI智能收件箱

DuRoBo Krono:搭载AI助手的智能手机尺寸电子阅读器

OpenAI推出ChatGPT Health医疗问答功能

Anthropic寻求3500亿美元估值融资100亿美元

Azure AI Week 直播课表公布,12月10 -12日线上见

微软、谷歌云和AWS第三季度云业绩对决

微软Azure上线基于Arm架构的Cobalt 100 CPU虚拟机

微软精心打造Rust虚拟机管理程序,为Azure工作负载提供动力

微软公布详尽计划,将分阶段对Azure用户强制做出MFA要求

市场分析:AWS、微软和谷歌云2024年第二季度云业绩对决

微软公布Azure Logic应用混合部署预览,“睽违已久”的C#内联操作终于落地

Oracle Autonomous Database服务登陆Azure

西门子与微软合作实现数字孪生定义语言标准化

Dell APEX File Storage for Microsoft Azure助力企业实现全面AI