李开复零一万物发布大模型Yi-34B ,阿里云魔搭社区开源首发

11 月 6 日,李开复博士带队创办的AI2.0公司零一万物正式开源发布首款预训练大模型 Yi-34B,模型开放商用申请,已在阿里云魔搭社区ModelScope首发。魔搭第一时间推出了模型部署相关教程,供开发者参考并快速上手。

零一万物此次开源的Yi系列模型包含34B和6B两个版本。据 Hugging Face英文开源社区平台和C-Eval中文评测的最新榜单,Yi-34B 预训练模型取得了多项 SOTA 国际最佳性能指标认可,成为全球开源大模型“双料冠军”。

零一万物创始人及 CEO 李开复博士表示:“零一万物坚定进军全球第一梯队目标,从招的第一个人,写的第一行代码,设计的第一个模型开始,就一直抱着成为‘World's No.1’的初衷和决心。”

Yi-34B 登顶全球英文及中文权威榜单 No.1

在 Hugging Face英文测试公开榜单Pretrained预训练开源模型排名中,Yi-34B以70.72 分位列全球第一,碾压 LLaMA2-70B 和 Falcon-180B 等众多大尺寸模型。

Hugging Face Open LLM Leaderboard (pretrained) 大模型排行榜,Yi-34B高居榜首(2023 年 11 月 5 日)

在 C-Eval中文权威榜单排行榜上, Yi-34B超越了全球所有开源模型。对比GPT-4,在 CMMLU、E-Eval、Gaokao 三个主要的中文指标上,Yi-34B 也具有绝对优势。

C-Eval 排行榜:公开访问的模型,Yi-34B 全球第一(2023 年 11 月 5 日)

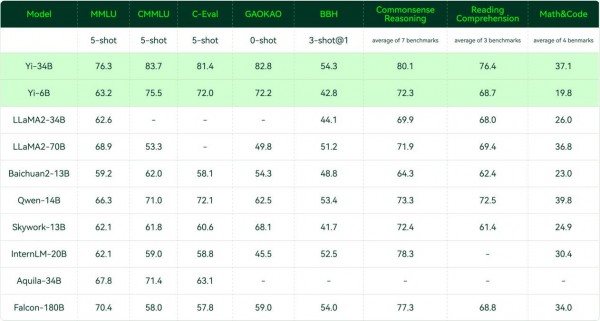

在全球大模型各项评测中最关键的 MMLU(Massive Multitask Language Understanding 大规模多任务语言理解)、BBH 等反映模型综合能力的评测集上,Yi-34B 同样表现突出,在通用能力、知识推理、阅读理解等多项指标评比中全部胜出。

各评测集得分:Yi 模型 v.s. 其他开源模型

和 LLaMA2 一样,Yi 系列模型在 GSM8k、MBPP 的数学和代码评测表现略逊 GPT 模型。未来,零一万物的系列开源计划中将推出代码能力和数学能力专项的继续训练模型。

全球最长200K 上下文窗口

Yi-34B模型将发布全球最长、可支持200K超上下文窗口(context window)版本,可以处理约40万汉字超文本输入。上下文窗口是大模型综合运算能力的金指标之一,对于理解和生成与特定上下文相关的文本至关重要。

受限于计算复杂度、数据完备度等问题,上下文窗口规模扩充从计算、内存和通信的角度存在各种挑战。为此,零一万物技术团队实施了一系列优化,包括计算通信重叠、序列并行、通信压缩等,实现了在大规模模型训练中近100倍的能力提升,也为Yi系列模型上下文规模下一次跃升储备了充足“电力”。

AI Infra实测实现 40%训练成本下降

李开复曾经表示,“做过大模型 Infra 的人比做算法的人才更稀缺”。超强的 Infra 能力是大模型研发的核心护城河之一。

AI Infra(AI Infrastructure 人工智能基础架构技术)涵盖大模型训练和部署提供各种底层技术设施,包括处理器、操作系统、存储系统、网络基础设施、云计算平台等等。

零一万物 Yi系列大模型基于阿里云平台打造,阿里云强大的智能算力基础设施为模型训练提供了稳固的基石。零一万物的Infra 技术通过“高精度”系统、弹性训和接力训等全栈式解决方案,确保训练高效、安全地进行。

凭借强大的 AI Infra,Yi-34B模型训练成本实测下降40%,实际训练完成达标时间与预测的时间误差不到一小时,进一步模拟上到千亿规模训练成本可下降多达 50%。目前,零一万物 Infra 能力实现故障预测准确率超过 90%,故障提前发现率达到 99.9%,不需要人工参与的故障自愈率超95%。

零一万物组建了由前 Google 大数据和知识图谱专家领衔的数据团队,建设了高效、自动、可评价、可扩展的智能数据处理管线;还自研出一套“规模化训练实验平台”,用来指导模型的设计和优化。数据处理管线和加大规模预测的训练能力建设,把以往的大模型训练碰运气的“炼丹”过程变得极度细致和科学化。

李开复宣布,零一万物已启动下一个千亿参数模型的训练。

接下来,零一万物将基于 Yi系列大模型,打造更多To C超级应用。李开复强调,“AI 2.0 是有史以来最大的科技革命,它带来的改变世界的最大机会一定是平台和技术,正如 PC 时代的微软 Office,移动互联网时代的微信、抖音、美团一样,商业化爆发式增长概率最高的一定是 ToC 应用。零一万物邀请开发者社群跟我们一起搭建 Yi 开源模型的应用生态系,协力打造 AI 2.0 时代的超级应用。”

好文章,需要你的鼓励

奥运级别的努力:首席信息官为2026年AI颠覆做准备

AI颠覆预计将在2026年持续,推动企业适应不断演进的技术并扩大规模。国际奥委会、Moderna和Sportradar的领导者在纽约路透社峰会上分享了他们的AI策略。讨论焦点包括自建AI与购买第三方资源的选择,AI在内部流程优化和外部产品开发中的应用,以及小型模型在日常应用中的潜力。专家建议,企业应将AI建设融入企业文化,以创新而非成本节约为驱动力。

字节跳动发布GAR:让AI能像人类一样精准理解图像任何区域的突破性技术

字节跳动等机构联合发布GAR技术,让AI能同时理解图像的全局和局部信息,实现对多个区域间复杂关系的准确分析。该技术通过RoI对齐特征重放方法,在保持全局视野的同时提取精确细节,在多项测试中表现出色,甚至在某些指标上超越了体积更大的模型,为AI视觉理解能力带来重要突破。

Spotify推出AI播放列表功能让用户掌控推荐算法

Spotify在新西兰测试推出AI提示播放列表功能,用户可通过文字描述需求让AI根据指令和听歌历史生成个性化播放列表。该功能允许用户设置定期刷新,相当于创建可控制算法的每周发现播放列表。这是Spotify赋予用户更多控制权努力的一部分,此前其AI DJ功能也增加了语音提示选项,反映了各平台让用户更好控制算法推荐的趋势。

Inclusion AI推出万亿参数思维模型Ring-1T:首个开源的超大规模推理引擎如何重塑AI思考边界

Inclusion AI团队推出首个开源万亿参数思维模型Ring-1T,通过IcePop、C3PO++和ASystem三项核心技术突破,解决了超大规模强化学习训练的稳定性和效率难题。该模型在AIME-2025获得93.4分,IMO-2025达到银牌水平,CodeForces获得2088分,展现出卓越的数学推理和编程能力,为AI推理能力发展树立了新的里程碑。

为AI+而生,海辰储能发布全球首款锂钠协同AIDC全时长储能解决方案

长时储能开启智慧未来:海辰储能生态日全球首发三大新品

Arm 借助融合型 AI 数据中心,重塑计算格局

奥运级别的努力:首席信息官为2026年AI颠覆做准备

Spotify推出AI播放列表功能让用户掌控推荐算法

Adobe押注生成式AI获得回报,年度营收创历史新高

OpenAI与迪士尼达成十亿美元合作协议,米老鼠和漫威角色进入Sora

甲骨文150亿美元数据中心投资导致股价下跌

Spoor鸟类监测AI软件需求飞速增长

制药行业AI数据质量危机:垃圾进垃圾出的隐患

Harness获得2.4亿美元融资,估值达55亿美元,专注自动化AI编码后的开发流程

英伟达CEO黄仁勋独家专访:万亿美元押注AI工厂将成为新时代计算机