AMD和英特尔联手了?!

相信大家这几天都被一则新闻刷屏——AMD和英特尔联手向英伟达发起挑战!乍看这则新闻令人匪夷所思,毕竟在接近半个世纪的时间里,AMD和Intel这对“冤家”上演了多场科技行业的经典对决!而分析人士指出,双方的合作倒也在情理之中,因为三者未来的竞争,已不在PC领域,而在这个正在来到我们身边的——AI的最好时代。”

伴随信息技术的发展,传统产业与信息化相结合,催生出智能制造、智能交通、智能物流、智能家居、智能家庭服务机器人、智慧健康养老等一批新业态新模式。“智能产业”的出现,为人工智能的发展提供了广阔的行业应用空间,极大促进了人工智能产业化进程。

在今年3月5日两会上发布的2017年政府工作报告中,明确指出要加快培育壮大包括人工智能在内的新兴产业,“人工智能”首次被写入了政府工作报告。

而此前,2016年国务院印发《“十三五”国家科技创新规划》,提出“面向2030年,再选择一批体现国家战略意图的重大科技项目”。经过千余名专家多轮论证,最终形成15个项目立项建议,中国科技部副部长阴和俊表示,结合当前人工智能迅速发展的态势,计划在已有的15个项目的基础上新增“人工智能2.0”,目前已进入实施方案的最终论证阶段。

人工智能在中国的政治、经济、学术领域都成为重中之重。这是中国 AI人最好的时代——2017年,中国人工智能迎来真正的新纪元。

激发“深度学习”潜能

人工智能发展是计算机硬件、软件技术演进的产物,其技术要素主要包括四个方面:

智能的传感系统,包括各类用于信息数据采集和环境感知的传感器件和设备;

智能的指挥中枢,主要指用于代替人脑的处理器芯片;

智能的信息处理算法,包括一切用于辅助人脑或模拟人脑进行认知学习、思维分析的软件算法;

海量的学习数据,为人工智能机器学习提供充足的先验样本。

互联网、移动互联网的蓬勃发展积累了海量的学习样本,深度学习算法的提出从软件层面模仿了人类大脑对底层信号的分级处理和特征提取,使得学习目标更精准、更有效,一批应用于语音和图像识别、机器翻译、机器搜索等领域的神经网络软件产品纷纷涌现。

然而,现有的神经网络分布式算法几乎全部建立在传统的集中式计算硬件架构基础上,在计算效率、能耗开销等方面存在严重的软硬件不匹配,无法从根本上发挥人工智能技术的优势,迫切需要从底层硬件层面加以解决,人工智能产业链重心开始向底层硬件迁移。

人工智能主要技术实现——深度学习,实质是通过构建具有很多隐层的机器学习模型和海量的训练数据,来学习更有用的特征,从而最终提升分类或预测的准确性;抽象层面越高,越有利于分类。

大数据+深度学习:颠覆传统行业计算与分析方式

深度学习架构概览

深度学习的建议配置

训练阶段(For training use),clusters of 8-32GPUs

-

Best perf, perf/W, perf/$, and memory bandwidth

-

Training of DL has forwarding (inference) and backward calculation flow with high frequent data exchange between layers

-

Need inter-GPU bandwidth –Nvidia support up to 8 direct GPGPU memory mapping

-

Benefits from Higher CPU/Memory frequency

-

Need performance storage for some cases, e.g. ImageNet

-

Need local storage capacity

-

GPU RDMA direct required and MPI compliant preferred

-

“Less intra-node traffic, More in-chassis traffic” could improve computation efficient by task (8xGPGPU in one chassis get largest interest today)

-

HPC compliant with certain PCIe Switch topology design

预测阶段(For inference),数据中心使用CPU或单个GPU, e.g. Tesla M4/P4 and M40/P40。

在移动设备上的预测阶段(For inference in mobile devices,如车联网,或物联网), 使用CPU或mobile TX1 。

获取最佳性能及效率(For the absolute best performance and efficiency),使用ASIC

-

确认设备相符(memory limited ASICs no better than GPU)

-

确认运算法则不会发生改变(your algorithm isn’t going to change)

最多节省几周时间!得GPU者得AI

CPU在一次计算一条指令(单指令单数据)方面表现出色,该指令在少量数据上运行。这涵盖绝大多数应用程序。但是,当处理大量数据或者需要最快的处理时,其他技术就会发挥作用。

GPU提供单指令多数据计算。一个指令可以一次处理大量的数据。例如,将两个数字向量相加。这是非常有效的,但是很难编程,并且许多问题不能映射到这个模型中。

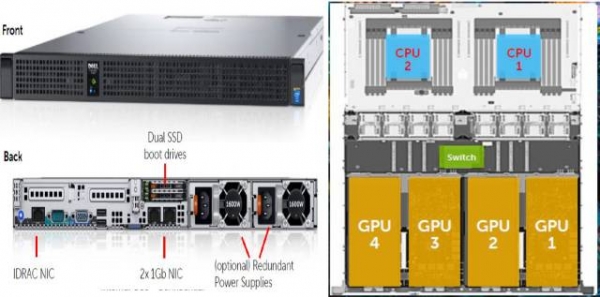

Dell PowerEdge C4130 GPU优化型服务器可在专为高性能计算(HPC) 工作负载和虚拟桌面基础架构(VDI) 而设计的超高密度平台中提供超级计算敏捷性和性能。在不影响多功能性或数据中心空间的情况下,加速处理医药、金融、能源勘探及相关领域中最复杂的研究、仿真和虚拟化问题。

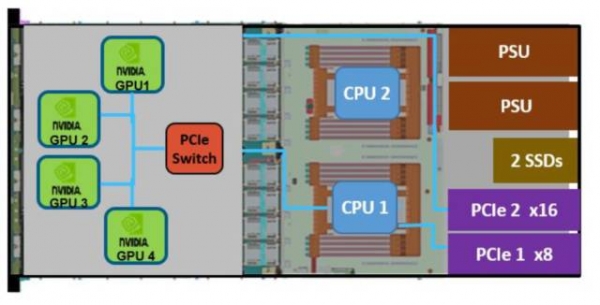

PowerEdge C4130外观与内部结构设计

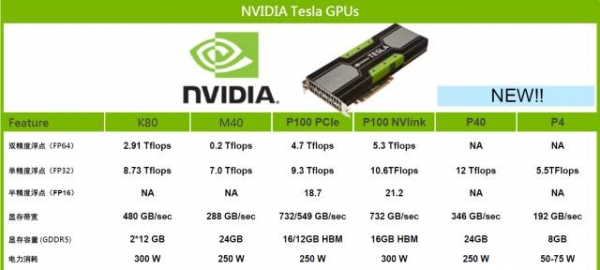

NVIDIA是当前深度学习/AI领域最火的硬件厂商,P100是其最强大的GPU。Dell PowerEdge C4130支持四块P100,在深度学习领域是非常先进的计算/加速平台。

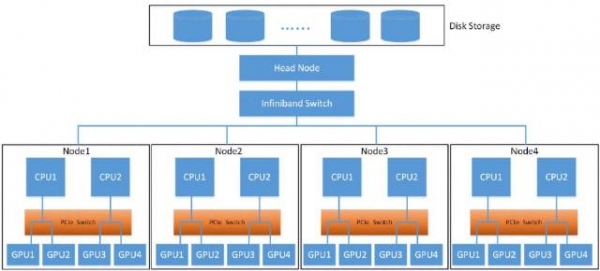

P100的深度学习集群配置:

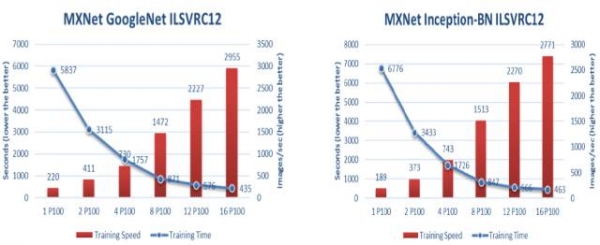

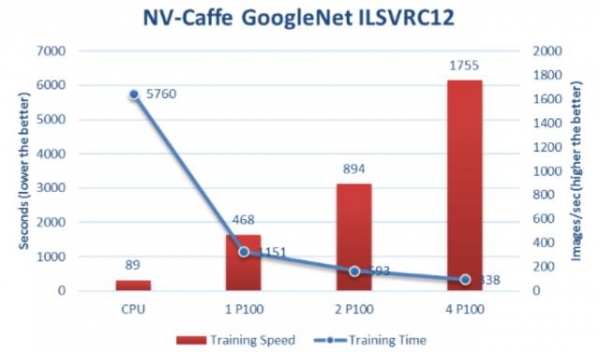

使用P100 GPU在NV-Caffe中的

GoogleNet的培训速度和时间

使用P100 GPU在MXNet中的培训速度和时间

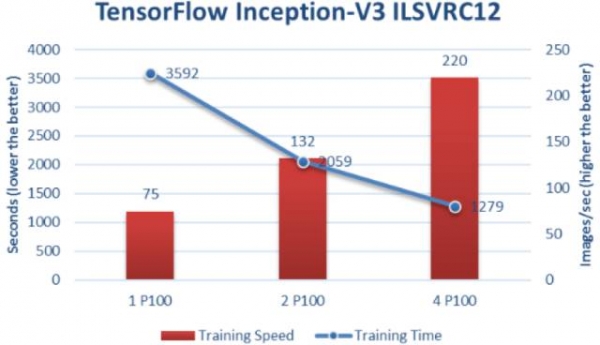

使用P100 GPU的TensorFlow中

Inception-V3的训练速度和时间

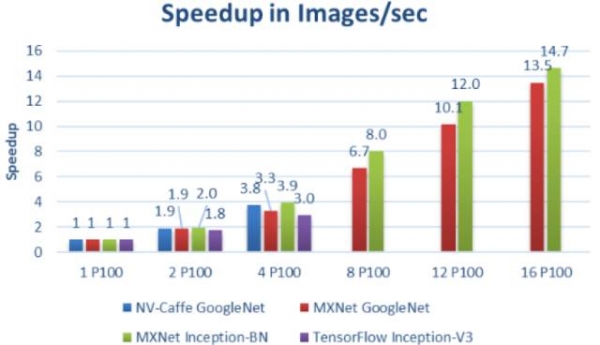

不同Deep Learning框架

和网络中多个P100 GPU的加速

在Dell PowerEdge C4130服务器中使用多个P100 GPU并使用多个服务器节点时,可以看到神经网络训练的极大的加速和可扩展性。随着P100 GPU数量的增加,训练速度增加,训练时间减少。

从显示的结果看,很明显,戴尔的PowerEdge C4130集群是一个强大的工具,大大加快神经网络训练。

在实践中,真实的用户应用程序可能需要几天或几周的训练模型。例如,真实应用的训练可能需要120个图像的90个时期。带有P100 GPU的戴尔C4130可以在不到一天的时间内打开结果,而CPU耗时大于1周 ——显而易见,这对最终用户是真正的好处。

实际使用情况的效果是每次运行节省几周的时间,而不是几秒。

PowerEdge C4130 GPU支持

Dell PowerEdge C4130服务器支持NVLink技术,NVLink是一种高带宽且节能的互联技术,能够在CPU-GPU 和GPU-GPU 之间实现超高速的数据传输。

NVLink技术的数据传输速度是传统PCIe3.0速度的5到12倍,能够大幅提升应用程序的处理速度。

PowerEdge C4130支持NVlink(chassis K)

深度学习的训练(training)阶段很花时间,Dell PowerEdgeC4130服务器+P100的配置能够充分满足其对于硬件的要求;而针对深度学习的inferrence阶段,建议采用Dell PowerEdgeR730服务器+Nvidia P4加速平台来搭建,确保获得优异性能的同时,实现功耗低、成本低。

好文章,需要你的鼓励

奥运级别的努力:首席信息官为2026年AI颠覆做准备

AI颠覆预计将在2026年持续,推动企业适应不断演进的技术并扩大规模。国际奥委会、Moderna和Sportradar的领导者在纽约路透社峰会上分享了他们的AI策略。讨论焦点包括自建AI与购买第三方资源的选择,AI在内部流程优化和外部产品开发中的应用,以及小型模型在日常应用中的潜力。专家建议,企业应将AI建设融入企业文化,以创新而非成本节约为驱动力。

字节跳动发布GAR:让AI能像人类一样精准理解图像任何区域的突破性技术

字节跳动等机构联合发布GAR技术,让AI能同时理解图像的全局和局部信息,实现对多个区域间复杂关系的准确分析。该技术通过RoI对齐特征重放方法,在保持全局视野的同时提取精确细节,在多项测试中表现出色,甚至在某些指标上超越了体积更大的模型,为AI视觉理解能力带来重要突破。

Spotify推出AI播放列表功能让用户掌控推荐算法

Spotify在新西兰测试推出AI提示播放列表功能,用户可通过文字描述需求让AI根据指令和听歌历史生成个性化播放列表。该功能允许用户设置定期刷新,相当于创建可控制算法的每周发现播放列表。这是Spotify赋予用户更多控制权努力的一部分,此前其AI DJ功能也增加了语音提示选项,反映了各平台让用户更好控制算法推荐的趋势。

Inclusion AI推出万亿参数思维模型Ring-1T:首个开源的超大规模推理引擎如何重塑AI思考边界

Inclusion AI团队推出首个开源万亿参数思维模型Ring-1T,通过IcePop、C3PO++和ASystem三项核心技术突破,解决了超大规模强化学习训练的稳定性和效率难题。该模型在AIME-2025获得93.4分,IMO-2025达到银牌水平,CodeForces获得2088分,展现出卓越的数学推理和编程能力,为AI推理能力发展树立了新的里程碑。

为AI+而生,海辰储能发布全球首款锂钠协同AIDC全时长储能解决方案

长时储能开启智慧未来:海辰储能生态日全球首发三大新品

Arm 借助融合型 AI 数据中心,重塑计算格局

奥运级别的努力:首席信息官为2026年AI颠覆做准备

Spotify推出AI播放列表功能让用户掌控推荐算法

Adobe押注生成式AI获得回报,年度营收创历史新高

OpenAI与迪士尼达成十亿美元合作协议,米老鼠和漫威角色进入Sora

甲骨文150亿美元数据中心投资导致股价下跌

Spoor鸟类监测AI软件需求飞速增长

制药行业AI数据质量危机:垃圾进垃圾出的隐患

Harness获得2.4亿美元融资,估值达55亿美元,专注自动化AI编码后的开发流程

英伟达CEO黄仁勋独家专访:万亿美元押注AI工厂将成为新时代计算机

英特尔的AI PC进行时

英特尔酷睿Ultra 9 200H系列焕新能力:120B MoE大模型,智能感官觉醒

英特尔携手生态伙伴共筑边缘AI生态,加速具身智能应用落地

英特尔携本地生态伙伴发布双路冷板式全域液冷服务器,引领数据中心散热与能效革新

向新而生,同“芯”向上 2025英特尔技术创新与产业生态大会在重庆举行

英特尔明年上线的18A制程平台,能否成为“AI原生”拐点?

AMD 锐龙AI MAX+ 395问鼎“技术王座”"春雨计划"润泽智慧万象

人工智能落地“最后一公里”,戴尔工作站助力AI应用提速

英特尔公布2025年三季度财报:营收137亿美元,同比增长3%

英特尔人工智能全球影响力嘉年华,中国创新力量崭露头角