戴尔科技数据缩减技术有效提高系统存储性能

上面

是戴尔PowerStore中端存储

可实现4:1的数据缩减率

下面

是戴尔PowerProtect DD备份存储

可实现65:1的数据缩减

同样用来“存数据”

为什么数据缩减率

差别这么大?

这个问题,相信很多企业级的小伙伴和我有一样的疑问。

相对于备份存储动辄达到50:1、65:1的数据缩减比例,而主存储往往只有“可怜”的3:1,4:1。难道是备份存储所使用的数据重删、压缩算法更先进,更高效?

如果是算法导致,为什么不用在主存储上?这对于寸金寸“容量”的存储设备来说,所带来的经济效益实在太诱人了。

而要回答这个问题,我们得先知道什么是重复数据删除技术和数据压缩技术(IT老司机可略过这部分)。

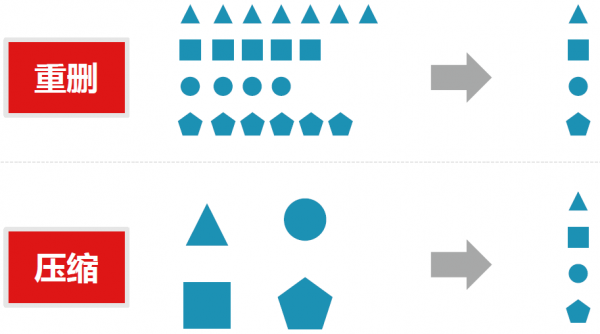

重复数据删除技术是指仅在存储介质上保留数据的一个唯一实例,冗余数据被替换为指向唯一数据副本的一个指针。当两个或多个文件具有相同的内容时,重复数据删除会将文件分成多个段,仅存储每个唯一文件段的一个副本。

而数据压缩技术是指在不丢失有用信息的前提下,缩减数据量以减少存储空间,从而提高其传输、存储和处理效率,或按照一定的算法对数据进行重新组织,减少数据的冗余和存储的空间的一种技术方法。

▼一图看懂数据重删和压缩▼

影响数据缩减率的

因素有哪些?

答案是虽然主存储和备份存储都以存储数据为目的,但两者对于数据缩减技术有着完全不同的考量。

首先,数据缩减是备份设备的核心功能,提供更高的数据缩减率,是这类产品的主要诉求。

而对主存储来说,数据缩减只是附加功能之一,而为了避免数据缩减产生大量的计算资源占用,影响到业务应用的读写,因此在数据缩减的使用上,往往有许多顾虑与限制。

另一方面,备份设备也因为自身的高比率数据缩减功能,使其也被局限在备份、归档这类静态的存储应用,而不适合需要频繁读取与写入的一般业务应用。原因有以下两点:

?第一,高比例的数据缩减会占用大量的计算资源,从而影响其他业务应用,因此很难在运行数据缩减的同时,还能正常提供一般的读写服务。

?其次,经过重复数据删除或数据压缩技术处理过的数据,必须先还原成原始数据,才能供前端主机读取与使用,而主存储中的数据,往往是那些需要频繁读取的活跃数据。

因此,以占用系统资源的方式频繁地缩减与还原数据,是无意义的,也是资源的浪费。

此外,影响数据缩减率的另一个因素是,它取决于你有多少相同或相似类型的数据:

●数据保存期设置:数据保存的时间越长,重复数据删除引擎发现重复数据的可能性也越大。

●数据类型:一些数据天生比较容易出现重复。如果网络里存在大量的Windows服务器,或者VMware虚拟机,就有希望得到更高的数据缩减率。

●变化速率:数据变化的速率越低,发现重复的机会也就越高。

●数据备份策略:全备份(相对于增量备份和差异备份)的频率越高,数据缩减的潜力也就越大,因为每天的数据有大量的重复。

可以看到,由于归档和备份系统的数据,大部分都是冗余数据,因此天生就可以实现更高的数据缩减率。

最后,是技术问题

比如戴尔PowerProtect DD备份存储拥有高达65:1的数据缩减率,放眼业界同类产品都是顶尖的存在,这就源于其独有的数据缩减专利技术。

而戴尔PowerStore虽然“只有”4:1的数据缩减率,但其数据缩减功能是“始终可用”。意味着PowerStore在数据缩减时不会额外占用控制器的CPU资源,几乎对性能不会产生影响。

这也让企业用户不再陷入性能下降与节省成本的两难,而让数据缩减在主存储真正发挥了用武之地。

*戴尔PowerStore采用英特尔®至强®可扩展处理器,该处理器可以优化工作负载,可靠性强,还有高计算力、高稳定性和高效敏捷性,不仅帮助PowerStore轻松满足既定工作负载,也可以为数字化变革做好准备。

最后,总结一下。为什么备份存储与主存储的数据缩减率差别巨大?

答案是两种产品的设计思路不同,存储数据的类型不同,因而不能直接进行数据缩减率的比较。

“搞存储,不忽悠,

我们是认真的!”

END

如果您想了解更多有关戴尔科技的产品和解决方案信息,请扫描以下二维码咨询戴尔官方客服。

来源:戴尔

好文章,需要你的鼓励

RLDP:卢森堡大学让隐私保护AI训练的颠覆性突破——一种自学习的“智能管家“让数据安全与模型效果完美共存

卢森堡大学研究团队开发的RLDP框架首次将强化学习应用于差分隐私优化,创造性地解决了AI训练中隐私保护与模型效果的矛盾。该方法如同智能教练,能动态调整隐私保护策略,在四种语言模型上实现平均5.6%的性能提升和71%的训练时间缩短,同时增强了抗隐私攻击能力,为敏感数据的AI应用开辟了新路径。

北大团队揭秘AI安全训练为何如此脆弱——大模型中隐藏的“弹簧效应“

这项由北京大学人工智能研究院完成的研究,首次从数据压缩理论角度揭示了大型语言模型存在"弹性"现象——即使经过精心安全对齐,模型仍倾向于保持预训练时的行为分布。

腾讯混元团队发布MixGRPO:让AI图像生成训练效率提升71%的混合式加速方案

腾讯混元团队联合北京大学提出MixGRPO技术,通过混合ODE-SDE采样策略和滑动窗口机制,将AI图像生成训练效率提升50%-71%,同时在多项人类偏好评估指标上超越现有方法。该技术采用"从难到易"的渐进优化策略,专注于图像生成早期阶段的重点优化,并引入高阶求解器进一步加速训练过程,为AI图像生成的产业化应用提供了更高效可行的解决方案。

高途x人大:在教育的深处,种下“有温度的AI”

北大团队揭秘AI安全训练为何如此脆弱——大模型中隐藏的"弹簧效应"

AI地震检测技术:像戴上眼镜一样清晰

医疗集团CIO采用AI提升生产力,在联络中心谨慎推进AI应用

仅需250个恶意文档就能让大语言模型产生后门漏洞

CIO们利用AI助力IT采购决策,超八成决策者已开始使用

AI拥抱并扩展企业软件市场,资金持续涌入

Spotify已可连接ChatGPT:互动功能体验升级

量子计算公司IonQ获得20亿美元融资加速商业化进程

Apple 收购计算机视觉初创公司 Prompt AI

Windows Copilot现可创建Office文档并连接Gmail

用上18A的英特尔至强6+,究竟“+”了什么?