工程师笔记|服务器OS升级找不到网卡怎么办?

在UEFI方式下,使用网卡对高密度服务器上的OS进行升级时,设备设置里突然找不到网卡了怎么办?本文依托戴尔易安信PowerEdge C6420,以Linux操作系统为例,实际演示了遇到此种状况该如何解决,供相关人员参考。

一背景:

某客户在去年购买了戴尔易安信的高密度服务器PowerEdge C6420,此双路服务器在一个超高密度的2U机箱中提供多达4台独立热插拔,具备充足的计算、内存、存储、连接和机箱选项,配置灵活,在I/O方面支持OCP标准的25G网卡,可以满足客户高带宽、低延迟的需求。

春节过后,客户要升级OS,启用UEFI方式安装。在启用UEFI的过程中,遇到了一个问题:

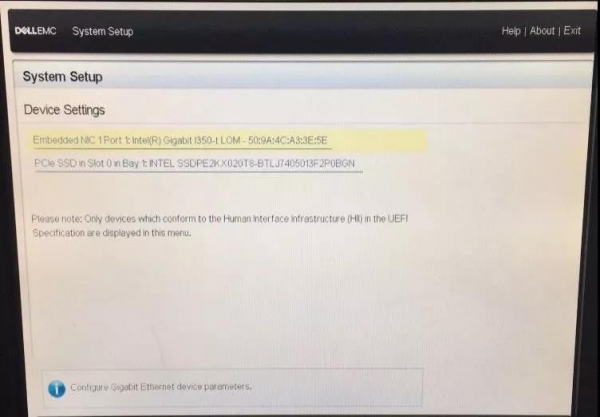

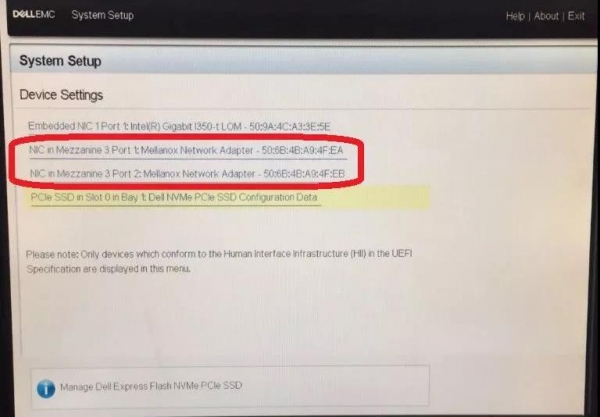

Device Settings中看不到Mellanox 25G网卡▼

这下真是巧夫难为无米之炊了,要利用网卡进行服务器OS升级,结果却找不到对网卡操作的选项,很多人面对这种情形就进行不下去了。不过别着急,都是有解决办法滴,请查收下面这套有图有字的详细攻略。

二解决方法(以Linux操作系统为例)

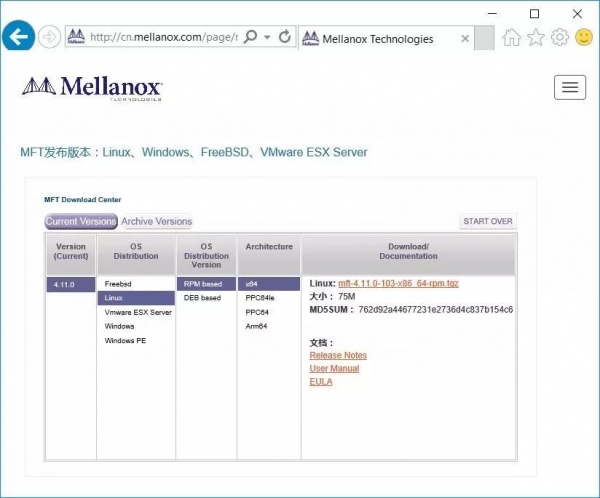

① 从Mellanox官网下载MFT工具:

http://www.mellanox.com/page/management_tools

② 选择Linux版本的RPM包▼:

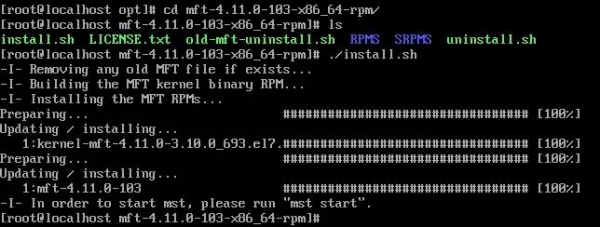

③ 完成下载后,将其拷贝到Linux中,并进行解压:

tar zxvf mft-4.11.0-103-x86_64-rpm.tgz

④ 然后开始安装MFT工具▼

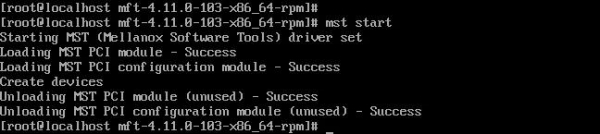

⑤ 安装完成后,启用MFT工具▼

mst start

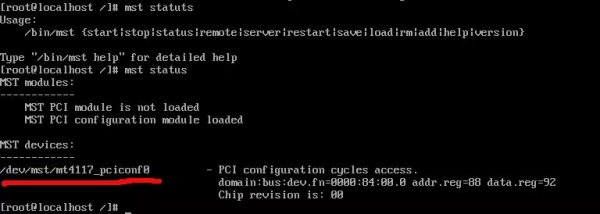

⑥ 获取device ID▼

mst status

设备名固定为【mt4117_pciconf0】

⑦ 依次执行如下命令▼

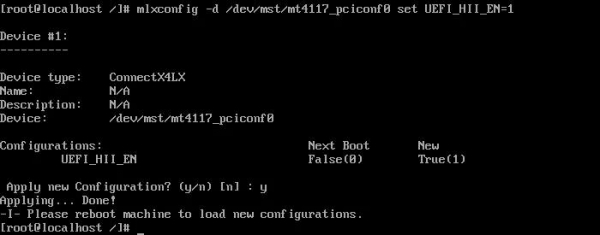

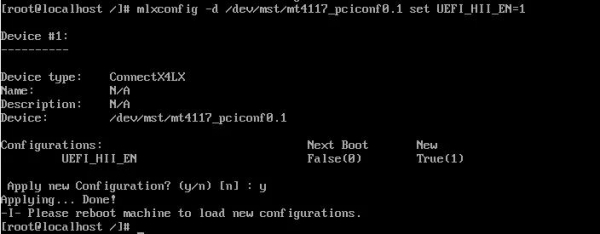

mlxconfig -d /dev/mst/mt4117_pciconf0 set UEFI_HII_EN=1

mlxconfig -d /dev/mst/mt4117_pciconf0.1 set UEFI_HII_EN=1

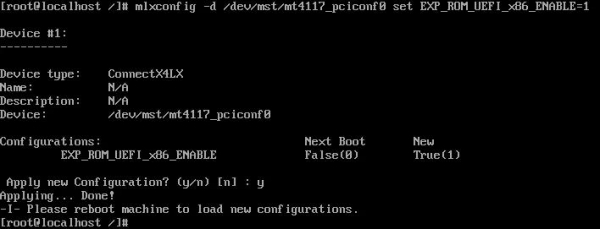

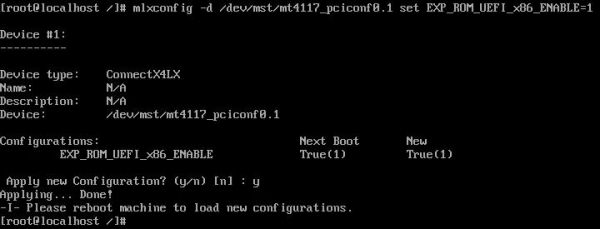

mlxconfig -d /dev/mst/mt4117_pciconf0 set EXP_ROM_UEFI_x86_ENABLE=1mlxconfig -d /dev/mst/mt4117_pciconf0.1 set EXP_ROM_UEFI_x86_ENABLE =1---->执行:mlxconfig -d /dev/mst/mt4117_pciconf0 set UEFI_HII_EN=1

执行: mlxconfig -d /dev/mst/mt4117_pciconf0.1 set UEFI_HII_EN=1

执行:mlxconfig -d /dev/mst/mt4117_pciconf0 set EXP_ROM_UEFI_x86_ENABLE=1

执行:mlxconfig -d /dev/mst/mt4117_pciconf0.1 set EXP_ROM_UEFI_x86_ENABLE =1

⑧ 完成以上操作后,重启服务器,进入BIOS界面▼

此时,在“Device Settings”界面里,就可以看到Mellanox网卡啦。

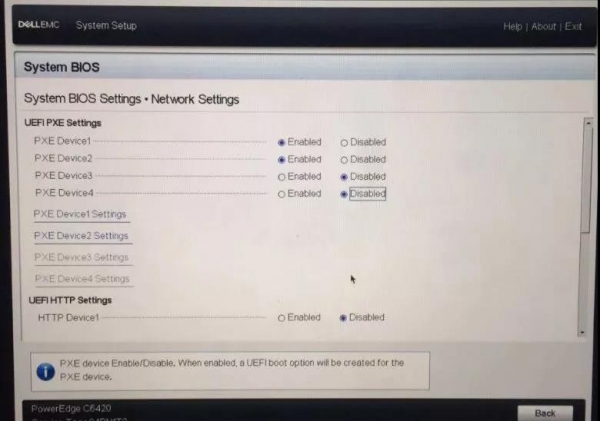

⑨ 看到UEFI网卡后,就可以进行网口的PXE设置了▼

三适用条件:

① 适用的物料:

Mellanox Connect X4 LX-EN 双端口 25G SFP+,PCIe3.0x8,OCP 夹层适配器 - DSS RESTRICTED(9R8DF)

② 适用机型:

PowerEdge C6420、PowerEdge R540、PowerEdge R740xd2、PowerEdge R7415、PowerEdge R6415

至此,问题已经圆满解决了。如果你也遇到此类问题,不妨试试这里介绍的方法吧!

来源:至顶网云计算频道

好文章,需要你的鼓励

奥运级别的努力:首席信息官为2026年AI颠覆做准备

AI颠覆预计将在2026年持续,推动企业适应不断演进的技术并扩大规模。国际奥委会、Moderna和Sportradar的领导者在纽约路透社峰会上分享了他们的AI策略。讨论焦点包括自建AI与购买第三方资源的选择,AI在内部流程优化和外部产品开发中的应用,以及小型模型在日常应用中的潜力。专家建议,企业应将AI建设融入企业文化,以创新而非成本节约为驱动力。

字节跳动发布GAR:让AI能像人类一样精准理解图像任何区域的突破性技术

字节跳动等机构联合发布GAR技术,让AI能同时理解图像的全局和局部信息,实现对多个区域间复杂关系的准确分析。该技术通过RoI对齐特征重放方法,在保持全局视野的同时提取精确细节,在多项测试中表现出色,甚至在某些指标上超越了体积更大的模型,为AI视觉理解能力带来重要突破。

Spotify推出AI播放列表功能让用户掌控推荐算法

Spotify在新西兰测试推出AI提示播放列表功能,用户可通过文字描述需求让AI根据指令和听歌历史生成个性化播放列表。该功能允许用户设置定期刷新,相当于创建可控制算法的每周发现播放列表。这是Spotify赋予用户更多控制权努力的一部分,此前其AI DJ功能也增加了语音提示选项,反映了各平台让用户更好控制算法推荐的趋势。

Inclusion AI推出万亿参数思维模型Ring-1T:首个开源的超大规模推理引擎如何重塑AI思考边界

Inclusion AI团队推出首个开源万亿参数思维模型Ring-1T,通过IcePop、C3PO++和ASystem三项核心技术突破,解决了超大规模强化学习训练的稳定性和效率难题。该模型在AIME-2025获得93.4分,IMO-2025达到银牌水平,CodeForces获得2088分,展现出卓越的数学推理和编程能力,为AI推理能力发展树立了新的里程碑。

为AI+而生,海辰储能发布全球首款锂钠协同AIDC全时长储能解决方案

长时储能开启智慧未来:海辰储能生态日全球首发三大新品

Arm 借助融合型 AI 数据中心,重塑计算格局

奥运级别的努力:首席信息官为2026年AI颠覆做准备

Spotify推出AI播放列表功能让用户掌控推荐算法

Adobe押注生成式AI获得回报,年度营收创历史新高

OpenAI与迪士尼达成十亿美元合作协议,米老鼠和漫威角色进入Sora

甲骨文150亿美元数据中心投资导致股价下跌

Spoor鸟类监测AI软件需求飞速增长

制药行业AI数据质量危机:垃圾进垃圾出的隐患

Harness获得2.4亿美元融资,估值达55亿美元,专注自动化AI编码后的开发流程

英伟达CEO黄仁勋独家专访:万亿美元押注AI工厂将成为新时代计算机