戴尔科技解决方案 助力医疗行业数字化升级和转型

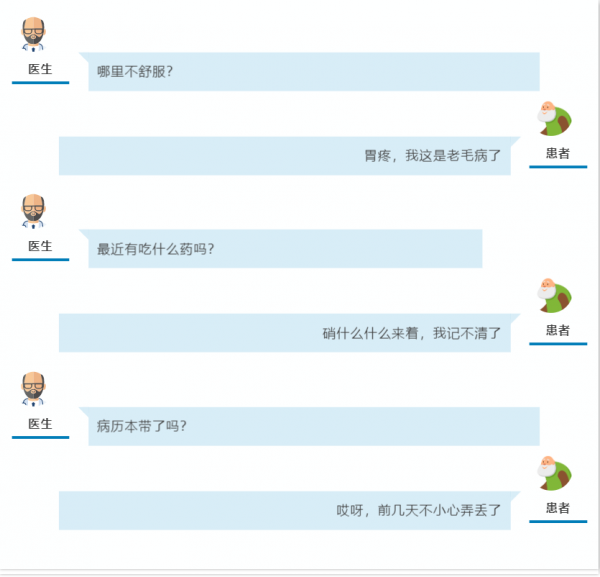

一段寻常的问诊对话,实际上反应了仍在完善的医疗服务问题:医患信息的共享与互通、医疗资源的均衡利用、病史的查询与调用……

实际上,不只是我们的医院正面临这样的问题,消除数据孤岛、提高医疗系统的灵活性是整个医疗行业IT亟待解决的事情。

医疗行业数字化转型

果实尚未成熟

随着数字化与各行业的融合逐渐深入,数字技术在行业发展中已不再局限于辅助的作用,其战略价值愈发显著。医疗行业也不例外,作为与人们生命安全与健康息息相关的行业,目前的医疗设备数字化已经初具规模,B超、CT等现代医疗设备在诊疗过程中已经发挥出了巨大作用。

医疗行业的数字化转型不是一蹴而就,在医疗体系层面,我们所面临问题的复杂程度并不比尖端医疗设备低。

例如老生常谈的数据孤岛问题,尽管大部分医院已经完成现代信息化基础设施的建设,但在工作开展的过程中,仍然会出现医疗信息传输不够顺畅,各部门数据和记录难以共通的情况,尤其是在疫情反复的当下,这一问题则更加显著。

医疗信息数据量大,存储管理困难也是问题清单的榜上常客,由于医院缺乏统一的数据管理能力和标准,或是缺乏合适的存储平台支撑等原因,常常导致数据存储管理困难,极易造成管理混乱,数据无法及时调用等问题。

除此以外,我们还面临着医疗办公协同程度低、医疗数据外流风险大等问题。

戴尔助力医疗行业

数字化转型

在这方面,作为全球领先的数字化解决方案供应商,戴尔科技集团长期以科技赋能各行各业,推动企业的数字化转型,拥有丰富的产品以及实践经验,得到国内外医疗行业的青睐。

例如汤斯维尔大学医院选择了戴尔科技集团的存储解决方案来加强医疗体系的建设,使医院工作人员能够提供更好的患者治疗效果并访问最新信息。

汤斯维尔大学医院(TUH)是汤斯维尔医院和卫生服务(HHS)的三级转诊医院,为昆士兰州北部的25万人提供专业的医疗保健、研究和教育服务,包括偏远地区的土著社区。

TUH拥有丰富的数字化改造经验,其数据实验室正在利用机器学习以及人工智能等新兴技术进行数字研究,以改善患者的临床结果。在进一步推进数字化转型的过程中,TUH发现其IT基础设施无法跟上逐渐发展的数字化需求:

病房中使用的仪表板的重新加载时间较长,并且获取准确的病史是一个缓慢的过程,因为必须找到患者记录并手动更新。

为了改变这一现状,TUH利用戴尔PowerStore构建单一的存储平台,以支持医院运行的混合工作负载。并结合PowerScale的高可用性和高成本效益,为非结构化数据提供单一的存储数据库。

*戴尔PowerStore采用英特尔®至强®可扩展处理器,该处理器可以优化工作负载,可靠性强,还有高计算力、高稳定性和高效敏捷性,不仅帮助PowerStore轻松满足既定工作负载,也可以为数字化变革做好准备。

利用该系统,TUH已经看到了病理学、微生物学、心脏病学和睡眠研究等临床媒体数据的增长,并将其利用到诊疗过程中,使其医疗体系能够始终跟上不断变化的数字化系统。

汤斯维尔HHS信息技术服务数字健康总监Barry Koch表示:

“戴尔科技集团的解决方案已成为医院数字化转型不可或缺的一部分,在复杂的环境中提供了一个以协作和健康为中心的解决方案,以支持我们的患者、临床医生和员工的数字化旅程,并通过了解和与健康服务合作,成为医院数字化转型不可或缺的一部分。”

更多数字化转型的最佳实践,欢迎收听我们在喜马拉雅上的智D有声栏目,与戴尔科技集团一起找出用科技撬动未来的专属路径。

END

如果您想了解更多有关戴尔科技的产品和解决方案信息,请扫描以下二维码咨询戴尔官方客服。

来源:戴尔

好文章,需要你的鼓励

爱立信与Orange携手打造可适应绿色网络

随着5G流量快速增长和新用例不断涌现,网络运营商需要在最小化环境影响的同时管理密集网络使用。Orange法国与爱立信合作开展创新试验,测试FDD大规模MIMO天线集成无线电,优化高流量区域频谱使用。双方还探索Cloud RAN和Open RAN架构,通过虚拟化RAN功能实现灵活的软件中心网络。合作重点关注利用AI驱动的自动化和意图驱动技术提升能源效率,在不影响性能的前提下动态调整网络资源以降低能耗。

谷歌DeepMind等顶级机构联合揭秘:为什么所有AI安全防护都是纸老虎?

谷歌DeepMind等顶级机构联合研究揭示,当前12种主流AI安全防护系统在面对专业自适应攻击时几乎全部失效,成功率超过90%。研究团队通过强化学习、搜索算法和人类红队攻击等多种方法,系统性地突破了包括提示工程、对抗训练、输入过滤和秘密检测在内的各类防护技术,暴露了AI安全评估的根本缺陷。

微软将Windows打造为“智能体操作系统“

微软正在将Windows 11改造为"智能代理操作系统",在任务栏中集成AI代理功能。新功能允许AI代理在后台执行任务,用户可通过任务栏图标查看进度状态。微软还在文件资源管理器中集成Copilot,提供文档摘要、文件问答等功能。此外,Click to Do功能得到改进,可将网页表格转换为Excel文档。这些AI功能采用本地AI和云端AI混合模式,为用户提供更智能的操作体验。

西蒙弗雷泽大学和Adobe研究院联手打造视频制作新神器:让静态图片学会“按剧本演戏“

西蒙弗雷泽大学和Adobe研究院联合开发的MultiCOIN技术,能够将两张静态图片转换为高质量的过渡视频。该技术支持轨迹、深度、文本和区域四种控制方式,可单独或组合使用。采用双分支架构和分阶段训练策略,在运动控制精度上比现有技术提升53%以上,为视频制作提供了前所未有的灵活性和精确度。

爱立信与Orange携手打造可适应绿色网络

微软将Windows打造为"智能体操作系统"

谷歌发布Gemini 3,新增编码应用并创基准测试纪录

Windows正在成为AI智能体的操作系统

macOS Tahoe 26.2支持Mac集群组建AI超级计算机

Lambda获得15亿美元融资建设AI数据中心

Gemini 3接近万能软件节点:AI成为全新用户界面

微软推出数字标牌模式,15秒后自动隐藏蓝屏死机界面

“我们曾是怪咖,我有阅读障碍,不看报表做决策”:5000亿美金市值后,美国AI落地标杆 Palantir CEO 谈20年反共识

圆满收官!2025年第二届中关村具身智能机器人应用大赛落幕,赛事亮点全面回顾

当宕机不可避免,混合云策略战略需具备多云弹性

返璞归真,行稳致远:SOLIDWORKS以AI赋能设计,渠道驱动增长